Per non appesantire troppo il discorso, ma soprattutto per renderlo accessibile anche ai lettori più inesperti, sono state talvolta usate delle semplificazioni, privilegiando la chiarezza al rigore.

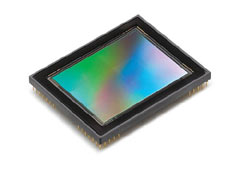

Fotografia è una parola che deriva dal greco e significa "scrivere con la luce". E' la luce, infatti, che attraverso l'obiettivo della nostra macchina fotografica arriva su un rettangolino più o meno grande che è, appunto, sensibile alla luce (fotosensibile). Questo rettangolino è il sensore, e nelle fotocamere digitali svolge la stessa funzione che, nelle macchine fotografiche tradizionali, svolgeva la pellicola. Davanti ad esso, come davanti alla pellicola, c'è una specie di velo che blocca la luce e che si alza quando si preme il pulsante di scatto: nell'intervallo di tempo in cui il sensore o la pellicola sono esposti alla luce, nasce l'immagine che poi vedremo su carta o sul monitor del computer. In estrema sintesi, dunque, il sensore serve a convertire la luce in elettroni. Ma com'è fatto un sensore? Per comprenderlo bisogna sapere cos'è un fotodìodo: è un dispositivo sensibile alla luce, che quando intercetta una determinata lunghezza d'onda (quella della luce, appunto), genera una carica elettrica.

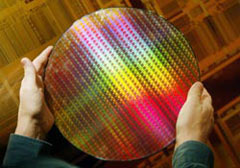

Un wafer di silicio (immagine AP Photos).

Bene, un sensore altro non è che un rettangolino di

silicio, pieno zeppo di fotodiodi e dotato dei vari

collegamenti necessari, sia interni che verso il resto

delle componenti della fotocamera. In pratica la griglia

di fotodiodi, solitamente di forma rettangolare, viene

innestata su un wafer (cioè una lastra circolare)

di silicio, ed al termine di un delicato processo

produttivo da ogni wafer si ricava un certo

numero di sensori. S'intuisce facilmente che, partendo

da una lastra di silicio di una data dimensione, più

sono grandi i sensori richiesti minore è il numero che

se ne riesce a tirar fuori. Insomma, data una torta, più

sono gli invitati più piccole saranno le fette, c'è poco

da fare! Questo è uno dei motivi per cui più il sensore

è grande, più costa.

Già, ma grande quanto?

Eccoci ad un altro aspetto di cui si discute spesso in

materia di sensori. Leggendo i dati tecnici delle fotocamere

si leggono frasi come <sensore APS> o <sensore da 1/8''> o

<sensore 4/3''>. Per decodificare questi numeri e queste

sigle bisogna fare un passo indietro. Storicamente,

nell'indicare le misure dei tubi catodici dei televisori ci

si riferisce al diametro del tubo in vetro che avvolge il

tubo catodico; questi diametri sono tipicamente mezzo

pollice, due terzi di pollice, e così via. Anche se

l'effettiva area d'immagine è inferiore al diametro (in

media infatti è i due terzi del diametro), per convenzione

si è sempre indicato il diametro del tubo. E per uno dei

tanti misteri della tecnologia (o del marketing),

nell'indicare le dimensioni dei sensori delle fotocamere (e

videocamere) digitali si è continuato ad usare quel tipo di

valori, persino oggi che i televisori a tubo catodico stanno

lasciando il passo a quelli al plasma o a cristalli liquidi.

In pratica, una sigla del tipo <sensore da 1/1,8''>, che si

legge "sensore da uno diviso uno virgola otto pollici" in

realtà indica un sensore grande circa 7,1x5,3 millimetri.

Certo, 1 diviso 1,8 dà 0,5555 pollici, che significa circa

14 millimetri (un pollice = 25,4 mm), ma questi 14mm, che su

un tubo catodico erano la diagonale, con il sensore della

nostra fotocamera digitale non c'entrano nulla: l'importante

è saperlo!

A puro titolo di esempio, nella tabella che segue c'è un

elenco di alcuni dei formati più diffusi:

Denominazione |

Larghezza |

Altezza |

1/1,8'' |

7,2mm |

5,3mm |

2/3'' |

8,8mm |

6,6mm |

4/3'' |

18mm |

13,5mm |

APS-C |

Circa 23mm |

Circa 16mm |

Pellicola "piccolo formato" |

36mm |

24mm |

I primi due (insieme a molti altri di dimensioni inferiori) sono tipici delle compatte, mentre quello APS-C è tipico delle fotocamere reflex ad obiettivi intercambiabili.

APS, chi era costui?

Si sarà notato che alla voce "APS-C" si sono indicate misure

approssimative. Perché? Bisogna fare un passo indietro. APS

è una sigla che sta per Advanced Photo System, un sistema

fotografico (che richiedeva fotocamere e rullini appositi)

lanciato alcuni anni fa che utilizzava una pellicola di

dimensioni ridotte rispetto ai classici rullini che tutti

conosciamo (quelli in cui ogni fotogramma misura 24x36mm).

Tra le caratteristiche dell'APS, che commercialmente non ha

mai sfondato, c'era la possibilità di scattare foto in tre

formati diversi:

- Classico (APS-Classic, ovvero APS-C: 23,4x16,7mm), così

definito perchè rispettava il rapporto 2:3 della pellicola

(cioè il lato lungo è grande una volta e mezza il lato

corto)

- HDTV, ovvero APS-H: ogni fotogramma misurava 30,2x16,7mm,

con un rapporto tra i lati di 16:9, adatto quindi ai

televisori di nuova generazione

- Panorama, ovvero APS-P: ogni fotogramma misurava

30,2x9,5mm, quindi presentava un marcato effetto panorama

Ora, le fotocamere digitali ad obiettivo intercambiabile

adottano – salvo pochi modelli che usano un sensore grande

quanto la pellicola, cioè 24x36mm – sensori che hanno misure

simili a quelle dell'APS-C, con lievi differenze a seconda

del produttore e della fotocamera: 22,7x15mm, 22,2x14,8mm,

23,7x15,6mm, 23,6x15,8mm, e così via. Questo insieme di

formati viene generalmente indicato con la sigla "APS-C".

E i megapixel?

Abbiamo detto che ogni sensore è composto di un certo numero

di fotodiodi, disposti come una scacchiera. Ogni fotodiodo è

in grado di catturare una certa quantità di luce e per

conseguenza genera una carica elettrica, che viene raccolta

da dei circuiti pure disposti sul sensore e convogliata

verso i componenti della fotocamera preposti

all'elaborazione dell'immagine (insieme, purtroppo, al

rumore, che è una triste costante di tutte le

apparecchiature di questo tipo). Quindi le fotografie

digitali sono composte da un certo numero di punti (che non

a caso si chiamano anche pixel, che sta per Picture

Element), ed ogni punto è generato da un fotodiodo. Per

esempio, se da una fotocamera digitale si ottiene una foto

grande 2560x1920 pixel, sappiamo che il suo sensore ha in

tutto 4.915.200 fotodiodi (basta moltiplicare 2560 per

1920), cioè quasi cinque milioni. Insomma, è una fotocamera

da cinque megapixel.

In realtà ogni fotocamera ha sempre qualche pixel in più,

perché non tutti quelli presenti sul sensore vengono usati

per creare l'immagine (ma servono ad altri scopi, diciamo

così, "di servizio", relativi ad esempio alla temperatura

dei colori, al contrasto, e così via). Ecco perché talvolta

si parla di "risoluzione effettiva", indicando i pixel che

realmente sono utilizzati per formare la fotografia.

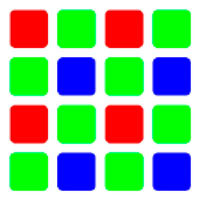

Un filtro Bayer

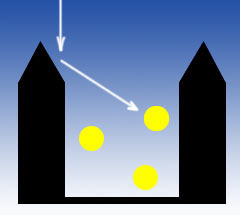

Delle microlenti indirizzano la luce

verso l'interno del fotodiodo

Pillola rossa o pillola blu?

C'è una triste verità che prima o poi ogni appassionato di

fotografia digitale scopre. I fotodiodi "vedono" in bianco e

nero, o meglio, non sono in grado di individuare il colore

della luce che hanno intercettato ed immagazzinato. Ma

allora come mai le foto escono a colori? Perché davanti ai

fotodiodi è posizionata una griglia composta di tanti

piccoli filtri colorati, ognuno di uno dei tre colori

primari (rosso, verde e blu; sono i tre colori che,

combinandosi, danno luogo a tutto l'insieme di colori che

l'occhio umano può percepire). Il tipo di filtro più diffuso

è quello denominato di Bayer (immagine a sinistra): si noti

che i filtri verdi sono più numerosi di quelli degli altri

due colori; questo avviene perché l'occhio umano è più

sensibile al verde, rispetto al rosso ed al blu, quindi il

filtro tende a replicare questa sensibilità. Ogni singolo

filtro lascia passare solo la luce del suo colore, quindi un

fotodiodo che ha davanti un filtro blu immagazzinerà solo la

luce blu, e così via per gli altri due colori.

Da notare che, per massimizzare la raccolta di luce, negli

spazi vuoti tra un fotodiodo e l'altro sono talvolta

posizionate delle microlenti che convogliano nel fotodiodo

luce che altrimenti sarebbe andata persa.

Una volta completata l'immagine, cioè la raccolta della luce

(più precisamente, ogni fotodiodo raccoglie il valore di

luminanza di un colore, cioè il rapporto tra l'intensità

luminosa e l'area della superficie che vi è esposta; si

esprime in candele per metro quadro, la sigla è Cd/m2), il

sistema di elaborazione della fotocamera analizza questo

insieme di dati (ognuno dei quali, lo ricordiamo, è relativo

ad uno solo dei tre colori primari) e, attraverso un

processo denominato "demosaicing", demosaicizzazione,

calcola quale sia il colore effettivo di ogni singolo punto,

prevalentemente grazie al confronto tra i pixel vicini. In

pratica, prendendo i pixel a gruppi – ad esempio – di

quattro alla volta, a seconda della distribuzione dei tre

colori primari il software della fotocamera ricostruisce il

vero colore della scena ripresa, e via via ripete questo

processo per tutti i gruppi di pixel dell'immagine.

Ma sono davvero cinque megapixel?

Ecco, ci sarebbe una seconda terribile verità... E' vero che

se un sensore ha 2560x1920 punti produce un'immagine

composta di cinque milioni di pixel, ma non è vero che

ognuno di questi cinque milioni di punti contenga anche

l'informazione relativa al colore (vero) di cui è composto:

abbiamo visto che ogni punto è solo di un colore primario, e

tutto il resto è… abilità del software.

In pratica, i 2560 pixel disposti sulla prima fila del

sensore sono metà rossi (o blu) e metà verdi; sulla seconda

fila avremo metà punti blu (o rossi) e metà verdi; e così

via. Quindi, se anziché parlare di "punti" in senso

generico, parliamo di "punti che contengono anche

un'informazione relativa al colore vero (non primario)", ci

rendiamo conto che, poiché come abbiamo visto la fotocamera

usa più pixel per arrivare a determinare il vero colore

della scena, è come se a nostra disposizione ci fossero metà

dei punti, sia in orizzontale che in verticale. Ovvero

1280x960, cioè circa 1,3 megapixel. Se non siete ancora

svenuti, potete consolarvi pensando che ognuno di questi 1,3

milioni di pixel contiene l'informazione relativa al colore

reale (della scena ripresa), e non più solo ad uno dei tre

colori primari.

Naturalmente esistono dei sistemi che limitano questo

problema della "finta risoluzione", il più semplice dei

quali è quello che, pur continuando a ricavare il colore

reale esaminando quattro pixel alla volta, analizza più

volte gli stessi pixel, combinandoli ogni volta in gruppi

differenti.

Più siamo meglio stiamo?

Si potrebbe pensare che il modo migliore per avere immagini

di alta qualità sia riempire il sensore di quanti più

fotodiodi possibile: più fotodiodi (più pixel) ci sono,

maggiore è la risoluzione dell'immagine finale; ed ecco

spiegato il continuo incremento di megapixel nelle

fotocamere che via via vengono lanciate sul mercato. Ma

basta ragionare un istante per rendersi conto che, se su un

sensore – poniamo – da 1/1,8'' prima c'erano quattro milioni

di fotodiodi, ed ora ce ne vanno sette, è evidente che si

stanno usando dei fotodiodi più piccoli. E più i fotodiodi

sono piccoli, meno sono capaci di catturare la luce, dunque

assieme al segnale da loro generato (l'immagine) c'è una

maggiore quantità di quello che viene definito "rumore",

cioè carica elettrica che sull'immagine finale si manifesta

sotto forma di puntini più o meno colorati e di dimensione

variabile.

Va osservato che qualunque dispositivo elettronico che abbia

a che fare con un segnale ha inevitabilmente un certo grado

di rumore. In generale, possiamo dire che esistono due tipi

di rumore, quello legato al segnale e quello indipendente

dal segnale stesso; quest'ultimo possiamo immaginarlo come

un inevitabile sottofondo di tutti i circuiti elettronici, e

semplificando potremmo dire che è generato proprio dalle

operazioni di trasferimento della carica elettrica dai

fotodiodi ai vari circuiti della fotocamera, dalla sua

conversione in un segnale digitale, e così via. Spesso lo si

definisce "rumore di lettura", "readout noise" in

inglese.

Per misurare il rumore spesso si preferisce indicarne la

quantità rispetto al segnale: è il cosidetto "rapporto

segnale/rumore" (in inglese SNR, signal-to-noise ratio).

Più è alto questo rapporto, minore è il rumore rispetto al

segnale.

L'aspetto pratico più importante che riguarda il rumore è

che esso diventa più visibile man mano che aumenta la

sensibilità a cui si scattano fotografie.

Ai tempi della pellicola, per scattare foto con poca luce si

caricava in macchina una pellicola ISO 400, o ISO 800, e

così via. Così facendo si utilizzava un supporto più

sensibile alla luce; ma nel caso del digitale il sensore non

si può sostituire, e la sua sensibilità è quella che è.

Quello che si può fare è amplificare maggiormente il segnale

raccolto dai fotodiodi, e questo comporta anche un aumento

del rumore prodotto. Come si amplifica il segnale dei

fotodiodi? Lo facciamo impostando, sulla nostra fotocamera

digitale, il valore ISO, aumentandolo a ISO 200, 400 o più.

In generale, più i fotodiodi sono piccoli e più sono

soggetti al rumore dipendente dal segnale, per cui le

compatte digitali generano immagini più rumorose, mentre le

fotocamere con sensori di formato APS-C riescono a fornire

immagini più pulite, anche a parità di risoluzione. Sarebbe

inesatto dire che questo avviene perché le compatte hanno

sensori più piccoli; è più giusto dire che il maggior rumore

dipende dai fotodiodi più piccoli.

In conclusione, se parliamo di rumore, più che la dimensione

del sensore in assoluto conta il suo... affollamento, cioè

quanti fotodiodi (e dunque quanti megapixel) ospita: meno ce

ne sono, più sono grandi, dunque minore è il rumore legato

al segnale.

Un esempio di rumore digitale

(visibile specialmente nella parte destra dell'immagine)

Dunque ci si trova di fronte a due forze contrastanti:

l'aumento del numero di pixel (cinque megapixel, sette

megapixel, e così via) produce immagini più definite, ma

allo stesso tempo peggiora la resa del sensore alle

sensibilità medio-alte.

All'atto pratico, quanto dovrebbe essere grande un

fotodiodo? Poiché la luce visibile ha una lunghezza d'onda

che va più o meno dai 400 ai 750 nanometri (un nanometro è

un milionesimo di millimetro), ovvero da 0,4 a 0,75 micron

(un micron, ovvero micrometro, è un milionesimo di metro),

perché un fotodiodo la catturi non può ovviamente essere più

piccolo di tali valori. Ad oggi, i fotodiodi delle compatte

hanno dimensioni che vanno dai 2 ai 3 micron, mentre quelli

dei sensori APS-C oscillano intorno ai 5-6 micron.

E' probabile che l'innovazione tecnologica consenta in

futuro di realizzare fotodiodi sempre più piccoli e meno

"rumorosi", ma questo non annulla il vantaggio che un

sensore più grande ha su uno di dimensioni inferiori, visto

che entrambi potranno beneficiare dei miglioramenti

tecnologici via via disponibili.

Quindi… bigger is better?

Se parliamo di qualità d'immagine, in generale più un

sensore è grande meglio è. Ma naturalmente tutto ha un

prezzo: sensori più grandi significa fotocamere più grandi,

maggior consumo di energia, obiettivi più grandi (perché

l'immagine che devono formare dev'essere grande almeno

quanto il sensore), e costi maggiori.

Usando sensori più ampi, i fotodiodi possono essere più

grandi: questo produce immagini meno "rumorose", come

abbiamo visto, e con una gamma dinamica più ampia. Cos'è la

gamma dinamica? Sintetizzando, è un'espressione che indica

l'intervallo di sfumature dal bianco puro al nero pieno che

un sensore è in grado di registrare. Un fotodiodo di ampie

dimensioni può immagazzinare, a parità di tempo, più luce

rispetto ad uno più piccolo, e dunque produrre un'immagine

più ricca di passaggi tonali, perché riesce a raccogliere

più informazioni sull'intensità luminosa di un punto

immagine. E' un po' come avere due lampade, una con un

normale interruttore, che può essere solo "accesa" o

"spenta", ed una con un potenziometro, dove tra "acceso" e

"spento" c'è la possibilità di impostare una gamma di

luminosità intermedie.

Per mettere alla prova la gamma dinamica basta fotografare

una scena dove ci sia una forte differenza di luminosità tra

le zone chiare e quelle scure, pensiamo ad esempio ad un

bambino all'ombra di un albero con un cielo molto luminoso

sullo sfondo. Se nella foto il bambino risulterà chiaro e

leggibile, il cielo sarà un uniforme lenzuolo bianco senza

nessuna sfumatura. Più i fotodiodi sono piccoli, più le

immagini sono esposte a questo rischio.

Un esempio di alte luci "pelate", come

si usa dire. A sinistra lo scatto intero, a destra un

dettaglio ingrandito. Come si vede la facciata degli edifici

non ha alcun dettaglio

CCD o CMOS?

No, non si tratta dell'ennesimo partito della galassia

postdemocristiana. Semplicemente i sensori si dividono in

due categorie, appunto CCD (Charge-Coupled Device,

dispositivo ad accoppiamento di carica) e CMOS (Complementary

Metal Oxide Semiconductor). I processi di fabbricazione

dei due sensori sono differenti, così come lo è la

disposizione dei circuiti su di essi, fermo restando che si

tratta sempre di piastrine piene di fotodiodi che raccolgono

la luce e la convogliano.

Ai fini fotografici la differenza più rilevante è quella

relativa proprio alla raccolta di luce. Nei CCD la carica

elettrica immagazzinata dai singoli fotodiodi viene

trasferita, accumulandosi man mano lungo le file di

fotodiodi, fino ai bordi del sensore, dove poi viene

amplificata ed infine convertita in un segnale digitale (da

un apposito ADC, Analog-to-Digital Converter). In

pratica la carica elettrica viene letta una riga alla volta,

e poi il parziale (di ogni riga) viene riportato alla riga

successiva e così via, in sequenza, fino a coprire l'intero

sensore.

Chi ha studiato un po' di elettronica si rende conto che in

un sensore CCD, dunque, viene trasportata della carica

elettrica. I sensori fabbricati con un processo di tipo

CMOS, invece, lavorano diversamente: ogni fotodiodo dispone

di un amplificatore e di un convertitore, quindi la carica

elettrica accumulata viene convertita in differenza di

potenziale – il cui trasporto richiede molta meno energia.

Se tutto questo vi dice poco, limitatevi a prendere atto

solo della conseguenza più evidente: a parità di altre

condizioni, un sensore CMOS consuma meno di un sensore CCD.

Senza dilungarsi sui dettagli delle due tipologie di

sensori, possiamo elencare alcuni punti fermi riguardo i

sensori di tipo CMOS:

- tendono ad essere di più facile fabbricazione e più

economici

- consentono di implementare stesso sul sensore dei

componenti che i sensori CCD non ospitano

(l'amplificatore, l'ADC), e questo porta alla

realizzazione di chip più piccoli: ciò spiega perché i

sensori di tipo CMOS sono la norma sui cellulari, sulle

fotocamere compatte, e così via

- come detto, a parità di altre condizioni consumano (e

scaldano) di meno

A questo punto verrebbe da chiedersi perché si trovino

ancora in giro dei CCD – ed anzi perché i sensori destinati

ai dorsi medio formato, prodotti di elevata qualità e dalla

squisita vocazione professionale (per non parlare dei

prezzi) realizzati da nomi come Hasselblad-Imacon e Phase

One, siano sempre e solo CCD. La risposta è: qualità

d'immagine. I sensori CCD hanno le potenzialità per offrire

una maggiore gamma dinamica, meno rumore e maggiore

sensibilità.

Non che i CMOS non vadano bene, intendiamoci: attualmente

tutte le reflex – anche quelle professionali – del marchio

leader di mercato, Canon, sono basate su sensori di tipo

CMOS. La verità è che non esiste una tecnologia

intrinsecamente superiore all'altra, perché il risultato

finale dipende da come la tecnologia viene implementata.

In generale i sensori CMOS hanno due limiti: il rumore e la

sensibilità. Poiché c'è un amplificatore per ogni fotodiodo,

basta una minima disuniformità nel funzionamento di uno o

più di questi amplificatori per generare pixel irregolari

e/o disturbati: di qui la maggiore tendenza al rumore, per

minimizzare la quale naturalmente esistono vari sistemi sui

quali non ci dilunghiamo. Inoltre, proprio la maggiore

presenza di circuiteria sul sensore genera più rumore

rispetto ad un CCD - perché, come si è detto più sopra, un

po' di rumore accompagna inevitabilmente ogni componente

elettronico.

Quanto alla sensibilità, sempre perché i sensori CMOS

ospitano più circuiti (rispetto ai CCD), ne deriva che una

parte della loro superficie non è destinata alla raccolta di

luce (la percentuale di un punto realmente utilizzata per

raccogliere luce si chiama "fill factor") ma appunto

ad ospitare tali circuiti; a questo si può ovviare adottando

delle microlenti, come descritto più sopra, e naturalmente

il miglioramento dei processi produttivi consente di

fabbricare circuiteria sempre più piccola (e quindi di

"sprecare" meno spazio sul sensore).

Agostino Maiello © 02/2007

Riproduzione Riservata

Altri articoli sull'argomento già pubblicati su Nadir Magazine:

- IL SENSORE: CHE COS'E', A COSA SERVE?

- LE DIMENSIONI DEI SENSORI DELLE FOTOCAMERE DIGITALI

- LE DIMENSIONI DEL SENSORE E LE DIMENSIONI DI STAMPA

- SENSORI ZONALI

- I MILLIMETRI NON SONO IMPORTANTI

- APS-C VERSO 4:3: DIMENSIONI A CONFRONTO

- RIFLESSIONI E CONSIDERAZIONI SULLA FOTOGRAFIA DIGITALE, ANCHE RISPETTO ALLA CARA VECCHIA PELLICOLA. DIMENSIONI DEI SENSORI A CONFRONTO

- POLLICI, PIXEL, KILOBYTE...